Perspektiven der Radioastronomie:

„Low Frequency Array“ LOFAR

Die Geschichte der Radioastronomie ist eine beispiellose

Erfolgsgeschichte der modernen Wissenschaft und Technologie, und schickt sich

nun an zu einem neuen Quantensprung in die Zukunft der Astronomie. Schon heute

liefert die Radioastronomie einzigartige Bilder von energetischen Phänomenen im

Universum und erlaubt Experimente mit höchster Präzision, um fundamentale

Aussagen der Physik zu prüfen. Parallel dazu hat die mit der Radioastronomie verbundene

Technik längst auf breiter Front ihren Eingang in das Alltagsleben gefunden –

was zugleich Segen und Fluch ist. Zum einen, weil die irdisch erzeugte

Radiointerferenz einen ungestörten Radioempfang immer schwerer macht, zum

anderen aber, weil die preisgünstig und massenhaft hergestellte Technik völlig

neuartige und faszinierende Konzepte möglich macht. Dies drückt sich aus durch

eine Reihe neuer Projekte in der Radioastronomie, wie z.B. ALMA („Atacama Large Millimeter Array“), SKA (das „Square Kilometer

Array“), und LOFAR (das „Low Frequency

Array“). Letzteres – ein als Vorläufer von SKA im Meter-Wellenbereich

operierendes Teleskop – wird dabei direkt vor unserer „Haustür“ liegen und

einen riesigen Sprung vorwärts in der Radioastronomie bedeuten.

Abbildung 1: Radiopanorama der Milchstraße (nördliche

Hälfte), aufgenommen mit dem Effelsberg 100m-Teleskop bei 2,7 GHz. Das Zentrum

der Milchstraße (Sgr A) ist ganz rechts zu sehen, der

helle Bereich im rechten Drittel des Bildes ist die Cygnusregion

– Durchstoßpunkt eines Spiralarmes

Frühe wissenschaftliche Erfolge der Radioastronomie

Viele der frühen Entdeckung der Radioastronomie haben sich später als grundlegende Entdeckungen erwiesen. Nicht umsonst, ist die Radioastronomie mit bisher vier Nobelpreisen (siehe Kasten) der erfolgreichste Teil der beobachtenden Astronomie[1].

Die erste (vom Radiopionier Karl Jansky in den 30er Jahren) entdeckte Radioquelle war der Zentralbereich unserer Milchstraße. Mit modernen Teleskopen ist die Milchstraße längst in eine Unzahl interessanter Details aufgelöst worden (Abbildung ), und schon in den 50er Jahren wurde aufgrund der hellen Radiostrahlung das Galaktische Zentrum identifiziert und zur Grundlage unseres galaktischen Koordinatensystems gemacht – im optischen Bereich ist das Zentrum wegen starker Staubabsorption nicht zu sehen. Heute noch ist das Schwarze Loch im Zentrum der Milchstraße ein vorrangiges Ziel von Radiobeobachtungen und mit hochfrequenter Radiointerferometrie schicken sich Astronomen an, den Ereignishorizont des Schwarzen Lochs abzubilden (siehe „Schatten des Schwarzen Lochs im Galaktischen Zentrums“, SuW, 2000).

Kosmische Hintergundstrahlung

Später (1963) waren es Arno Penzias und Robert W. Wilson (Nobelpreis, 1978), die erkannten, dass das unvermeidliche Radiorauschen in den Empfängern eine astrophysikalische Signifikanz hatte. Diese kosmische Hintergrundstrahlung (Abbildung 2) ist das rotverschobene und erkaltete Glimmen des Urknalls aus der Zeit, als das Universum einen Phasenübergang von einem photonendominierten zu einem materiedominierten Zustand machte. Messungen dieses Hintergrunds durch die Satelliten COBE und WMAP und moderne Hochfrequenz-Radiomessungen von Ballons („Boomerang“ & „Maxima), aus der Atacama-Wüste (CBI), und vom Weltall bilden nun die Grundlage für die Vermessung der Geometrie des Universums und der Bestimmung seiner fundamentalen Konstanten (Dichte der Dunklen Materie, Dunkle Energie, Krümmungsradius, etc.).

Pulsare und Gravitationswellen

Ein weiterer signifikanter Sprung gelang – wie so oft – eher zufällig. Bei der Suche nach variablen, durch das interplanetare Medium szintillierenden Radioquellen, entdeckten Jocelyn Bell und Antony Hewish (Nobelpreis erstaunlicherweise nur für letzteren) die ersten Pulsare und damit eine neue Form von Materie – den Neutronenstern. Dieser Stern mit einer Masse von ca. 1,4 Sonnenmassen ist nur wenige Kilometer im Durchmesser und besteht aus einer dichten Packung Neutronen: ein einziger gigantischer elektrisch neutraler Atomkern. Die Rotation des Neutronensterns liefert ein ultrapräzises Zeitsignal im Radiobereich. Die darauffolgende Entdeckung eines Doppelpulsars und seiner Periodenänderung führte dann sogar noch zum Nachweis von Gravitationswellen (siehe Abbildung 3). Heute gehören Pulsarmessungen und auch die Radiointerferometrie (siehe nächster Abschnitt) zu den mit Abstand präzisesten astronomischen Messmethoden, mit denen Aussagen der fundamentalen Physik getestet werden können.

Natürlich hat es in der Radioastronomie nicht nur Nobelpreis-Arbeiten gegeben, sondern sie umfasst eine ganze Breite von Forschungsthemen, welche die gesamte moderne Astronomie umfassen – einige dieser Highlights sind im nebenstehenden Kasten zusammengefasst.

Die technologische Entwicklung

Die ersten Radioteleskope waren noch einfache

Konstruktionen aus Draht und Holz und im Prinzip nicht viel anders als ein

simpler Dipol. Eine gewisse Richtcharakteristik erreichte man dann schon bald

mit etwas ausgefeilteren Antennentypen, z.B. einer Yagi-Antenne,

wie manche sie noch als gewöhnliche Fernsehantenne auf dem Dach haben. Durch

den 2. Weltkrieg und die Entwicklung des Radars begünstigt, wurden dann nach

dem Krieg Parabolspiegel bei höheren Frequenzen eingesetzt..

Was mit Kriegstechnologie begann (wie z.B. dem deutschen „Würzburg-Riesen“),

entwickelte sich bald zu immer größeren universell einsetzbaren

Radioteleskopen. Die Giganten unter ihnen stehen heute in Deutschland (100m-Teleskop

in Effelsberg bei Bonn) und Amerika (Green Bank Teleskop, 100m effektiver

Durchmesser; sowie das nicht-schwenkbare Arecibo-Teleskop mit 305m

Durchmesser).

Die ersten Radioteleskope waren noch einfache

Konstruktionen aus Draht und Holz und im Prinzip nicht viel anders als ein

simpler Dipol. Eine gewisse Richtcharakteristik erreichte man dann schon bald

mit etwas ausgefeilteren Antennentypen, z.B. einer Yagi-Antenne,

wie manche sie noch als gewöhnliche Fernsehantenne auf dem Dach haben. Durch

den 2. Weltkrieg und die Entwicklung des Radars begünstigt, wurden dann nach

dem Krieg Parabolspiegel bei höheren Frequenzen eingesetzt..

Was mit Kriegstechnologie begann (wie z.B. dem deutschen „Würzburg-Riesen“),

entwickelte sich bald zu immer größeren universell einsetzbaren

Radioteleskopen. Die Giganten unter ihnen stehen heute in Deutschland (100m-Teleskop

in Effelsberg bei Bonn) und Amerika (Green Bank Teleskop, 100m effektiver

Durchmesser; sowie das nicht-schwenkbare Arecibo-Teleskop mit 305m

Durchmesser).

Die ersten Beobachtungen wurden zunächst im Bereich unterhalb von 100 MHz gemacht, aber schon bald erweiterte sich das Frequenzspektrum nach oben. 408 MHz galten zwar als ultra-hohe Frequenz (UHF!), aber inzwischen gibt es erfolgreiche Beobachtung bis hoch zu 1 THz. Damit erstreckt sich der von der Radioastronomie abgedeckte Frequenzbereich über 5 Zehnerpotenzen. Kaum eine andere astronomische Disziplin kann dabei mithalten. Für Beobachtungen bei den höchsten Frequenzen, d.h. bei Submillimeter-Wellenlängen, muss man natürlich spezielle Empfänger und Teleskope mit extrem akkurater Oberfläche benutzen. Beispiele für solche Submm-Teleskope sind das Heinrich-Hertz Teleskop auf dem Mt. Graham (Arizona) oder das gerade im Bau befindliche APEX- Teleskop („Atacama Pathfinder Experiment“) des MPI für Radioastronomie in Chile.. Die Spannweite der Empfangstechnologien, die von nur relativ wenigen radioastronomischen Instituten weltweit betreut wird, kann da schon zu einer größeren Herausforderung werden.

Ein instrumenteller Quantensprung in der Entwicklung der Radioastronomie war dann die Realisierung der Interferometrie und der Apertursynthese. Sie liegt inzwischen fast jedem neuen Großprojekt in der Radioastronomie zugrunde und auch bei optischen Teleskopen spielt sie eine immer wichtigere Rolle. Dabei werden zwei oder mehr Teleskope direkt oder virtuell (mittels Speichermedien oder Datenleitungen) miteinander gekoppelt. Die Radiosignale werden an einer zentralen Stelle miteinander korreliert, d.h. zur Interferenz gebracht. Das elektronisch aufgenommene Interferogramm enthält dann Informationen über die Struktur und Position der Radioquelle. Mittels geeigneter Rechnerprogramme können diese Informationen in eine detaillierte Karte der Radioemission am Himmel umgewandelt werden. Die erreichbare Bildschärfe nimmt mit dem Abstand der einzelnen Teleskope und der Frequenz zu. Verbindet man Radioteleskope auf verschiedenen Kontinenten, spricht man von interkontinentaler Radiointerferometrie (oder VLBI = Very Long Baseline Interferometrie). Dies liefert die höchste in der Astronomie verfügbare räumliche Auflösung – einen Faktor 1000 mehr als das Hubble-Space-Telescope – und entspricht der Auflösung eines virtuellen Einzelteleskops mit dem Durchmesser der Erde. Die kleinste bisher aufgelöste Struktur und damit der unangefochtene Weltrekord hat eine Größe von 18 mikro-Bogensekunden am Himmel (das entspricht der Größe einer Mandarine auf dem Mond).

Neue

Schritte in die Zukunft

Neue

Schritte in die Zukunft

Vergangene Großtaten sind natürlich kein Grund sich auf seinen Lorbeeren auszuruhen. Auch die Radioastronomie will und muss sich weiterentwickeln. Aufgrund der technologischen Reife der Technik und der engen Verbindung mit Industrierelevanter Forschung, bieten sich eine Vielzahl von Richtungen an, in denen es vorzustoßen gilt. Man kann sie grob in vier große Linien einteilen:

Erweiterung des Frequenzspektrums: Die Erschließung des gesamten von der Erde zugänglichen Frequenzbereiches war lange Zeit eines der größten Herausforderungen. Erst vor kurzem ist es gelungen bis zu 1 THz vorzustoßen – noch weiter und man kommt bereits in den Bereich der Infrarot-Astronomie. Damit ist formal der maximal mögliche Frequenz-Bereich erschlossen, aber natürlich stecken gerade die hohen Frequenzen noch in den Kinderschuhen. Hier liegen eine Vielzahl von Molekül- und Atomlinien, die es erlauben werden, die kosmische Chemie zu verstehen. Das ESO-Projekt ALMA wird beim Verständnis dieser Vorgänge eine entscheidende Rolle spielen. Aber auch die Frequenzen am untersten Ende des Spektrums, im MHz-Bereich, liegen schon seit Jahrzehnte brach und bietet hochinteressanten Stoff für eine neue Forschergeneration (siehe unten).

Räumliche Auflösung: Ein weiterer Treiber wissenschaftlicher und technischer Entwicklung ist die Jagd nach immer höheren räumlichen Auflösungen. Dies kann durch Vergrößern des Abstands von Teleskopen – der sogenannten Basislinie – in einem Interferometer oder durch die Erhöhung der Beobachtungsfrequenz geschehen. Die endliche Größe der Erde setzt der maximalen Basislänge aber eine harte Grenze, zu deren Überwindung nur Satelliten in Frage kommen. Tatsächlich hat es erfolgreiche erste Weltraum-VLBI-Experimente (mit dem japanischen Satelliten Halca/VSOP) gegeben, und kommende Missionen können darauf aufbauen. Der technologische und finanzielle Preis für diese Technik ist naturgemäß hoch.

Eine Erhöhung der Beobachtungsfrequenzen, als zweite Möglichkeit ist ebenfalls in vollem Gange, benannt als mm-VLBI bzw. submm-VLBI nach den verwendeten kurzen Wellenlängen. Mittelfristig wird dabei die VLBI-Technik von den großen mm-Wellen Projekten wie z.B. ALMA profitieren. Diese Technik hat zu dem oben erwähnten Auflösungsrekord geführt und wird als einzige in der Lage sein, in absehbarer Zeit direkte Abbildungen von Schwarzen Löchern zu liefern (Abbildung 4). Schon jetzt ist man in einigen Quellen bis auf 10-1000 Schwarzschildradien Entfernung vom zentralen Schwarzen Loch vorgedrungen und schon heute lassen sich Experimente mit höchster Präzision durchführen, die in der Astronomie ihresgleichen suchen: Eigenbewegungen und Parallaxen von vielen galaktischen Objekten, Zeitraffer-Filme von Supernova-Explosionen und Pulsationen von Sternatmosphären, Eigenbewegungen von Galaxien in der lokalen Gruppe, etc.

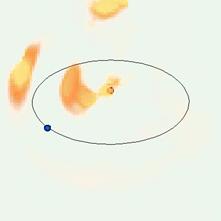

Abbildung

4: Computersimulation von hochauflösenden

Radio-Beobachtungen des Schwarzen Lochs im Zentrum der Milchstraße, die mit der

nächsten Generation von Radioteleskopen möglich sein wird (Falcke et al. 2000).

Die horizontale Achsenmarkierung gibt die räumliche Skala in Einheiten des

Gravitationsradius an, während die vertikale Skala relative Intensitätswerte

für vertikale (gestrichelte Linie) und horizontale (durchgezogene Linie)

Querschnitte durch das Bild angibt. Die

obere Reihe zeigt ein rotierendes und die untere Reihe ein nicht-rotierendes

Schwarzes Loch. Die mittlere und rechte Spalte zeigen Bilder, wie man sie mit Radiointerferometern

(VLBI) bei 0.6 und 1.3mm Wellenlänge für ein optisch dünnes Emissionsgebiet um

das Schwarze Loch im Zentrum der Milchstraße erwarten würde. Der Schatten des

Ereignishorizonts ist immer noch klar sichtbar und verspricht somit eine grundlegende

physikalische Entdeckung.

Empfindlichkeit: Einer der häufigsten Wünsche von Astronomen aller Wellenlängenbereichen ist der nach größerer Empfindlichkeit. Dies lässt einen tiefer und weiter in Raum und Zeit schauen und erlaubt es, auch qualitativ neue Phänomene zu studieren. Als eine Faustregel gilt, dass die nächste Generation von Teleskopen mindestens um einen Faktor 10 empfindlicher sein sollte als die vorherige. In der Langwellen-Radioastronomie konzentrieren sich die Planungen daher auf das SKA, also ein Teleskop das einen ganzen Quadratkilometer Sammelfläche aufweist.

Mit 0.008 km2 Sammelfläche gehört aber schon das 100-m-Radioteleskop in Effelsberg zu den Giganten unter den Teleskopen auf dieser Erde. Noch deutlich größere Einzelteleskope scheinen auf absehbare Zeit nicht sinnvoll zu sein. Aus diesem Grund kommen eigentlich nur noch verteilte Netzwerke von zusammengeschalteten Teleskopen in Frage, wie es z.B. beim Very-Large-Array (VLA, USA) oder dem Westerbork Synthesis Radio Telescope (WSRT, Niederlande) erfolgreich vorgeführt wird. Die genaue Größe dieser Einzelteleskope ist eine Frage der günstigsten Kalkulation und rangiert zur Zeit noch zwischen 4400 12m-Teleskopen und 30 200m-Teleskopen. Pilotprojekte in aller Welt sind nun damit beschäftigt, eine optimale Variante zu finden.

Zum Verständnis der Empfindlichkeiten muss man sich vergegenwärtigen, dass die grundlegende Flussdichte-Einheit der Radioastronomie das Jansky[2] ist. In den Anfängen der Radioastronomie beobachtete man Quellen im Bereich 10-1000 Jy, heute sind Empfindlichkeiten im milli-Jansky (mJy) Bereich üblich und mikro-Jansky (µJy) werden in langen Beobachtungen durchaus erreicht. Das SKA will nun in den nano-Jansky-Bereich (nJy) vordringen. Zusätzlich zur Vergrößerung der Sammelfläche der Teleskope gelingt das durch breitbandigere Filter und Korrelatoren, die einen größeren Teil des Frequenzspektrums auf einmal beobachtbar machen.

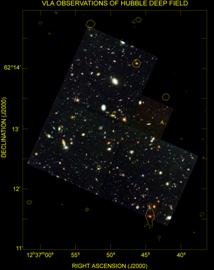

Das Vordringen in das nJy-Universum bringt aber nicht nur mehr Quellen (bis zu 100 Millionen neuer extragalaktischer neuer Quellen erwartet man), sondern verheißt auch einen qualitativen Sprung. Bislang war man insbesondere bei der hochaufgelösten Beobachtung extragalaktischer Objekte auf die sogenannte nicht-thermische Strahlung angewiesen: Synchrotronstrahlung von Elektronen, die sich mit fast Lichtgeschwindigkeit durch ein Magnetfeld bewegen. Thermische Emission von heißem Gas ist dahingegen viel schwächer und oft nur bei großen ausgedehnten Quellen zu detektieren. Die Empfindlichkeit eines Teleskops, thermische Quellen zu entdecken und aufzulösen, wird mit einer Grenz-Helligkeitstemperatur angegeben: Diese Helligkeitstemperatur gibt an, wie kalt ein Objekt sein darf, damit eine gerade noch räumlich aufgelöste Quelle detektiert werden kann. Im Moment liegt diese Grenz-Helligkeitstemperatur bestenfalls bei 1 Million Grad – einer Temperatur, die selbst die heissesten Sterne nicht erreichen. Das SKA verspricht dahingegen Empfindlichkeiten bis hinunter zu 10,000 Grad. Damit wird der Radioastronomie mit ihrer unerreicht hohen Auflösung im milli-Bogensekunden-Bereich die thermische Welt der Sterne und Gasnebel erschlossen. War bislang der Radiohimmel noch relativ leer im Vergleich zu manchen optischen Beobachtungen, so wird er in Zukunft Hubble-Space-Teleskop-Bildern – wie z.B. dem Hubble-Deep-Field – selbst nach relativ kurzer Integrationszeit in nichts nachstehen (Abbildung 5).

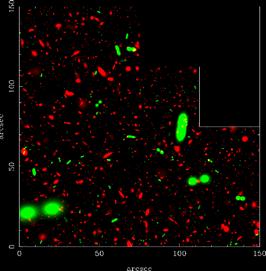

Abbildung

5: Simulation einer 8-Stunden Integration

des Radiohimmels mit dem SKA im charakteristischen Ausschnitt des Sichtfeldes des

Hubble-Weltraumteleskops (links). Rote Quellen symbolisieren Galaxien mit

Sternentstehung, grüne Galaxien sind aktive galaktische Kerne (Schwarze Löcher)

in Radiogalaxien. Zum Vergleich sieht man rechts das berühmte

Hubble-Deep-Field (mehrere Wochen Integrationszeit)

mit einer tiefen Radiointegration des VLA (weiße Konturen). Man sieht den

enormen Zuwachs an Radioquellen im Vergleich zur herkömmlichen Radiotechnik und

zu optischen Bildern (www.skatelescope.org).

Flexibilität: Eine völlig neuartige

Erweiterungsmöglichkeit bietet sich der Radioastronomie zur

Zeit aufgrund einer einzigartigen Eigenschaft von Radiowellen: fast

unbegrenzte Flexibilität durch direkte digitale Bearbeitung der Radiowellen und

die damit verbundene Möglichkeit, ein Teleskop fast komplett in Software zu

realisieren. Bei Radiowellen sind zwar die Energien der einzelnen Photonen

niedrig, aber genau deshalb haben sie auch niedrige Frequenzen, die

elektronisch verarbeitbar sind, und sie kommen mit hohen „Besetzungszahlen“ des

Phasenraums. Letzteres bedeutet nichts anderes, als dass „ein“

detektiertes Radiophoton in Wahrheit aus

einer Überlagerung vieler, exakt identischer Photonen besteht (analog den in

den letzten Jahren viel diskutierten Bose-Einstein

Kondensaten der Materie). Aus diesem Grunde sind Beobachtungen von langwelligen

Radiophotonen in der Regel nicht durch fundamentales Quantenrauschen oder

Unschärferelationen begrenzt, sondern werden durch klassische Wellenmechanik

beschrieben. Radiophotonen können daher, wenn sie in einem Detektor ankommen

(d.h. de facto in einem Antennendraht eine Wechselspannung induzieren) exakt

gemessen und digitalisiert werden, ohne dass man Information verliert. Die so

„digitalisierten Photonen“ können dann beliebig im Rechner weiter bearbeit und virtuell

zur Interferenz gebracht werden, wenn man mehrere Empfänger miteinander

koppelt. Dies geschieht im Prinzip in jedem modernen Radiointerferometer und

lässt sich, aufgrund gestiegener Rechnerleistung, nun dazu einsetzen, virtuelle

Radioteleskope bei niedrigen Frequenzen in Echtzeit komplett digital zu

konstruieren – selbst wenn die Empfänger alle in einer flachen Ebene stehen.

Hat man nämlich einmal die Photonen digitalisiert, kann man ihren Strahlengang

(also ihre relative Verzögerung), so wie er in einer Antennenschüssel verlaufen

würde, im Rechner nachbilden und beliebig verändern (Abbildung 6), bevor man

die Photonen in einen digitalen Brennpunkt zusammenbringt..

Flexibilität: Eine völlig neuartige

Erweiterungsmöglichkeit bietet sich der Radioastronomie zur

Zeit aufgrund einer einzigartigen Eigenschaft von Radiowellen: fast

unbegrenzte Flexibilität durch direkte digitale Bearbeitung der Radiowellen und

die damit verbundene Möglichkeit, ein Teleskop fast komplett in Software zu

realisieren. Bei Radiowellen sind zwar die Energien der einzelnen Photonen

niedrig, aber genau deshalb haben sie auch niedrige Frequenzen, die

elektronisch verarbeitbar sind, und sie kommen mit hohen „Besetzungszahlen“ des

Phasenraums. Letzteres bedeutet nichts anderes, als dass „ein“

detektiertes Radiophoton in Wahrheit aus

einer Überlagerung vieler, exakt identischer Photonen besteht (analog den in

den letzten Jahren viel diskutierten Bose-Einstein

Kondensaten der Materie). Aus diesem Grunde sind Beobachtungen von langwelligen

Radiophotonen in der Regel nicht durch fundamentales Quantenrauschen oder

Unschärferelationen begrenzt, sondern werden durch klassische Wellenmechanik

beschrieben. Radiophotonen können daher, wenn sie in einem Detektor ankommen

(d.h. de facto in einem Antennendraht eine Wechselspannung induzieren) exakt

gemessen und digitalisiert werden, ohne dass man Information verliert. Die so

„digitalisierten Photonen“ können dann beliebig im Rechner weiter bearbeit und virtuell

zur Interferenz gebracht werden, wenn man mehrere Empfänger miteinander

koppelt. Dies geschieht im Prinzip in jedem modernen Radiointerferometer und

lässt sich, aufgrund gestiegener Rechnerleistung, nun dazu einsetzen, virtuelle

Radioteleskope bei niedrigen Frequenzen in Echtzeit komplett digital zu

konstruieren – selbst wenn die Empfänger alle in einer flachen Ebene stehen.

Hat man nämlich einmal die Photonen digitalisiert, kann man ihren Strahlengang

(also ihre relative Verzögerung), so wie er in einer Antennenschüssel verlaufen

würde, im Rechner nachbilden und beliebig verändern (Abbildung 6), bevor man

die Photonen in einen digitalen Brennpunkt zusammenbringt..

Hat man die Wellen einmal digital vorliegen, kann man sie natürlich auch verlustfrei kopieren und reproduzieren. Damit lassen sich dann zusätzliche virtuelle Antennen nachbilden – im Englischen wird dies „Multi-Beaming“ genannt. Allein begrenzt durch die (immer weiter steigende) Rechnerleistung kann man so in beliebig viele Richtungen gleichzeitig schauen, seine Blickrichtung in Sekundenbruchteilen exakt ändern (entspricht dem Schwenken eines herkömmlichen Teleskops), und – falls man die Daten eine zeitlang speichert – auch noch ein paar Minuten in die Vergangenheit schauen („retrospektives Beamforming“) und den Himmel vor einem Ereignis studieren.

Es ist offensichtlich, dass die Möglichkeiten des retrospektiven Beamformings und des Multi-Beamings ganz neue Parameter-Bereiche der Astronomie zugänglich machen: zum einen sehr kurzlebige Phänomene („transients“), die unserer Aufmerksamkeit bisher entgangen sind, und zum anderen langwierige und tiefe Beobachtungen die Monate und Jahre an Integrationszeit benötigen. Letztere sind bisher schon aus rein (astro-)soziologischen Gründen nicht möglich: es gäbe einen Aufschrei der Empörung unter Astronomen, wenn man ein fortschrittliches und vielseitiges Teleskops für Jahre hinweg nur einer Gruppe und einem Experiment zugänglich machen würde – bei Physikern ist dies allerdings schon länger üblich.

Es daher nicht verwunderlich, dass die neuesten Konzepte von Radioteleskopen nun genau auf diese neuen Freiheiten des Multibeamings setzen: für das Square-Kilometer-Array ist die Technik vorgeschlagen und für LOFAR (dem LOw-Frequency-Array) ist sie zum Herzstück des Konzepts geworden. LOFAR – ursprünglich als SKA-Vorgänger bei den niedrigsten Frequenzen gedacht – hat sich inzwischen zu einem sehr eigenständigen und höchst interessanten Projekt entwickelt, dessen Realisierung in relativ kurzer Zeit zu erwarten ist und daher exemplarisch im Folgenden genauer diskutiert werden soll.

Abbildung 6: Prinzip eines „phased

Arrays“. Eine normales Radioteleskop (links) sammelt Photonen auf einer großen

Fläche und reflektiert sie auf einen Punkt. Durch mechanisches Schwenken des

Parabolspiegels kann man in verschiedene Richtungen schauen. Die Oberfläche des

Spiegels ist so gewählt, dass alle Photonen „phasen-gleich“ am Empfänger

ankommen, d.h. der Weg zum Fokus ist von jeder Stelle aus der gleiche. Bei

einem „phased Array“ stehen über die ganze Fläche

verteilt Empfänger, die die Radiowellen aufnehmen und dann elektrisch zu einem

Punkt weiterleiten, in dem sie vereinigt werden. Ebene Wellen von einem

entfernten Objekt, das nicht senkrecht über der Array-Ebene steht werden aus

geometrischen Gründen am dem Objekt abgewandten Ende später ankommen als am

Objekt zugewandten Ende. Zur Kompensation wird für jedes Empfangselement eine

elektrische Verzögerung („delay“), eingebaut, so dass

die Wellen am Ausgang des Arrays phasengleich ankommen. Die Elektronik dieses

so genannten „Beamformers“ macht somit das gleiche

wie die geneigte und gekrümmte Oberfläche der Antennenschüssel. Durch

Einstellung des Delays kann man nun die

Empfindlichkeitsrichtung des Arrays beliebig einstellen und in alle Richtungen

schauen. Durch Duplizieren der Eingangssignale und den Einbau weiterer Beamformer lässt sich sogar in mehrere Richtungen

gleichzeitig schauen (natürlich nur innerhalb der Empfindlichkeitskeule – dem

Gesichtsfeld – der primären Empfangselemente, aus denen das Array aufgebaut

ist).

LOFAR – Ein Radioteleskop und das Breitband-Internet der nächsten Generation.

Das Radioteleskop LOFAR (Abbildung 7) wird nach dem Prinzip des „phased arrays“ gebaut (s.o.,Abbildung 6) und verspricht nicht weniger als eine komplette Revolution bei niedrigen Frequenzen. Sein Einsatzbereich wird zwischen 10 und 220 MHz liegen und liefert bei den niedrigsten Frequenzen eine effektive Sammelfläche von einem Quadratkilometer. Die Wissenschaft in diesem Bereich ist extrem vielfältig und interdisziplinär – von der Kosmologie bist zur Klimatologie – und wird im nächsten Kapitel diskutiert. Das Grundlayout von LOFAR sind 100 Stationen, mit jeweils 100 simplen Dipolen und Analog/Digital-Wandlern, die über hyperschnelle Glasfaser – Internet der nächsten Generation mit 25 Tb/s – mit einem zentralen Superrechner verbunden sind (entsprechend der Leistung von 10,000 PCs). Die Stationen sind über 350 km verteilt und erlauben damit eine Auflösung von bis zu einer Bogensekunde. Herzstück des Arrays bildet ein virtueller Kern aus mindestens einem Viertel aller Antennen, die zu einer Super-Station zusammengeschaltet werden. Der Preis wird auf ungefähr 50-100 Millionen Euro geschätzt.

Abbildung

7: Der

grundsätzliche Aufbau von LOFAR besteht aus ca. 100 Stationen, die in einer

logarithmischen Spirale angeordnet und über 350 Kilometer verteilt sind. Das

Herz der Anlage soll im schwach besiedelten Gebiet in der Nähe des Westerbork

Radioteleskops angesiedelt werden, die weitere Verteilung der Stationen ist

aber noch nicht genau festgelegt. Jede Station besteht aus 100 nichtbeweglichen

Antennen (Dipole – invertiertes „V“ – plus Bodenabschirmung und Elektronik).

Die Daten werden über Glasfaser an den Zentralrechner geschickt, der dann virtuelle Teleskope synthetisiert mit denen man in

mehrere beliebige Richtungen gleichzeitig schauen kann.

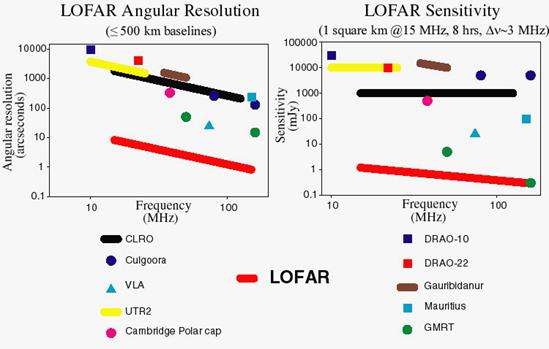

Begrenzt durch die Rechnerleistung – aber später flexibel erweiterbar – liefert das Teleskop gleichzeitig acht Antennenkeulen, mit denen man in beliebige Richtungen am Himmel schauen kann, wobei bei niedrigen Elevationen die Empfindlichkeit naturgemäß abnimmt. Die erwartete Empfindlichkeit am Zenit beträgt bis zu 2,4 mJy in nur einer Sekunde und bis zu 5 µJy in 100 Stunden bei 120 MHz – eine aufgrund von Multi-Beaming durchaus vernünftige Integrationszeit. Bei niedrigeren Frequenzen ist die Empfindlichkeit aufgrund des galaktischen Hintergrundes niedriger (68 mJy in einer Sekunde bei 30 MHz). Insgesamt sind die erreichbaren Empfindlichkeiten – insbesondere bei den niedrigen Frequenzen – um Größenordnungen besser als alles bisher Verfügbare (Abbildung 8). Extrapolation von Quellenstatistiken (in erster Linie normale Galaxien) zeigen, dass bei diesen Empfindlichkeiten LOFAR in den ersten Monaten schon bis zu 100 Millionen neue Quellen entdecken wird.

Abbildung

8: Das räumliche

Auflösungsvermögen und die Empfindlichkeit von LOFAR sind – insbesondere bei

niedrigen Frequenzen – erheblich besser als alle Vorgängerteleskope. Unterhalb von 74 MHz beträgt der Zuwachs bei

Auflösung und Empfindlichkeit drei Größenordnungen und darüber mindestens noch

eine. Dies ist bezogen auf nur einen „Beam“. Durch

den Einsatz von Multi-Beaming steigert sich die

Empfindlichkeit für LOFAR nochmals um einen großen Faktor. Hinzu kommen noch

Vorteile durch stark verbesserte Kalibrationsmöglichkeiten

und permanente Verfügbarkeit (das schmalbandige 74

MHz-System des VLA ist z.B. nur für wenige Tage im Jahr verfügbar).

Generisches Sensorennetzwerk – das nächste Internet

Ein höchst interessanter Aspekt von LOFAR liegt in seiner Datenverarbeitung. Tatsächlich steckt bei diesem Teleskop das meiste Geld im Datennetzwerk, in den Computern und natürlich in der Software. Die eigentlichen Empfänger – Dipole, Verstärker, und A/D-Wandler – verwenden Komponenten heutiger Alltagstechnik und sind entsprechend günstig. Sie produzieren allerdings Datenraten in bisher nicht gekanntem Ausmaß, die in Realzeit verarbeitet werden müssen. Dies erfordert den Aufbau neuartiger Netzwerktechnik, die um eine Größenordnung schneller sein muss als die bisher vorliegende und wird in Kollaboration mit Industriepartnern entwickelt. Die Verlegung von Glasfaserkabeln über weite Entfernungen ist im Prinzip ein geringeres Problem, da noch viele, im Rahmen des Internetbooms (Aktienbesitzer unter den Lesern werden sich schmerzhaft erinnern) vergrabene Kabel unbenutzt im Boden liegen („dark fibers“) – man muss nur wissen wo. Ist das Netz einmal aufgebaut, kann es auch für andere, z.B. kommerzielle Zwecke benutzt und vermietet werden.

Die Anschubfinanzierung für LOFAR kam daher auch aus Töpfen der Industrieförderung und auch die weitere Finanzierung des Netzwerkes kann man als Investition betrachten, die sich über die nächsten zehn Jahre wieder bezahlt macht. Im Rahmen dieser Argumentation ist nun ein großer Antrag über 73 M€ an den holländischen Staat im Rahmen des „Bsik“ Programms eingereicht worden. Das „Bsik“ Programm finanziert sich aus Überschüssen von der Öl und Gasförderung im Nordosten Hollands und soll dazu diesen Holland auch für die Zeit nach Erschöpfung der Vorräte wettbewerbsfähig zu halten.

LOFAR kann man noch weiter abstrahieren und als ein generisches Sensorennetzwerk betrachten. Hierbei sind eine Vielzahl von „Fühlern“ – es müssen ja nicht nur Radioantennen sein – miteinander verknüpft, die permanent Umwelteinflüsse messen, sie über das Netzwerk mitteilen und das Gesamtsystem darauf reagieren lassen können. Als zusätzliche Fühler werden Wetterstationen, Geophone und auch Teilchendetektoren geplant. Mit den Geophonen sollten seismische Veränderungen kontinuierlich studiert werden und Wetter- und Boden-Sensoren sollen helfen Präzisions-Landwirtschaft zu entwickeln. Der Aufbau weiterer solcher Netze ist mit LOFAR relativ kostengünstig zu machen und erlaubt einen in der Tat einzigartigen interdisziplinären Zugang zu unserer Welt und unserer Umgebung.

Von Kosmologie zur Klimatologie – Wissenschaft mit LOFAR

Es ist klar, dass man bei der Neu-Erschließung eines Frequenzraumes und einer signifikanten Steigerung von Empfindlichkeit und Auflösung in der Astronomie immer auch wissenschaftliches Neuland betritt. Trotzdem ist es sinnvoll sich bereits im Vorfeld Gedanken über die zu erwartenden Ergebnisse zu machen, damit man ein Teleskop auch entsprechend auslegt. Im Folgenden möchten wir eine Reihe von wissenschaftlichen Anwendungen von LOFAR herausheben und diskutieren.

Zeitalter der Reionisation

Die Kosmologie hat in den letzten Jahren große Fortschritte gemacht und trotzdem sind wir immer noch am Anfang. Eine große Frage ist diejenige nach dem Zeitpunkt der ersten Sternentstehung im Universum, als aus dem turbulenten, erkalteten Plasma des Urknalls plötzlich etwas qualitativ neues entstand: selbstleuchtende, energieverschwendende Materiebälle – also Sterne.

Nach dem Urknall kühlte das Plasma im jungen Universum schnell ab, bis es schließlich zur Rekombination von Elektronen und Protonen kam, die Wasserstoff und Helium als erste Elemente bildeten. Aus diesem neutralen Material bildeten sich dann die allerersten hell leuchtenden Sterne und Galaxien, die das Plasma im Universum durch ihre Strahlung wieder aufheizten und ionisierten. Diese Epoche der ersten Sternentstehung (u.U. auch der Entstehung der ersten Schwarzen Löcher) nennt man das „Zeitalter der Reionisation“ (Abbildung 9). Sie gilt als einer der letzten noch nicht entdeckten Epochen in der Standard-Kosmologie und ihr genaues Alter ist ein wichtiger aber bisher unbekannter Parameter.

Optische Spektroskopie von Quasaren grenzt diese Epoche auf eine kosmologische Rotverschiebung von z>7 ein, kann aber nicht weiter vordringen, da schon geringste Mengen neutralen Gases bei höheren Rotverschiebungen das Universum im visuellen Bereich optisch dick machen. Die neuesten Ergebnisse des Wilkinson MAP Experiments der NASA im Bereich von 22-90 GHz haben das überraschende Ergebnis gebracht, dass diese Epoche wahrscheinlich noch erheblich früher eingesetzt hat als bislang angenommen – vielleicht bei z=13-20. Warum dem so ist, bleibt noch im Dunkeln, aber LOFAR kann hier den entscheidenden Durchbruch bringen.

Neutrales atomares Gas produziert die bekannte 21 cm (1,4 GHz) Wasserstofflinie. Bei einer Rotverschiebung von z>7, würde diese Wasserstofflinie in den Frequenzbereich unterhalb von 200 MHz verschoben werden und sie kann von LOFAR detektiert werden. Zusätzlich zur Detektion dieser Epoche kann LOFAR dann auch noch die räumliche Strukturbildung statistisch untersuchen, ähnlich dem, was man bei Untersuchungen der kosmischen Hintergrundstrahlung im hochfrequenten Radiobereich schon macht.

Abbildung 9: Eine kurze Geschichte der Zeit. Nach dem Urknall

kam es zu Abkühlung und Rekombination des Urplasmas. Erst die erste Generation

von Sternen heizte es wieder auf und es entstand das heutige Universum mit

seinen Galaxien und seinem ionisierten intergalaktischen Medium, als dem

Überrest der Urknallmaterie. Dieses Zeitalter der Reionisation

kann mithilfe der rotverschobenen 21 cm Wasserstofflinie von LOFAR entdeckt werden.

Das erwartete Signal ist allerdings sehr klein (20 mK bei einem Hintergrundrauschen von 300 K) und man braucht schon viele Monate – wenn nicht Jahre – Integrationszeit, um sinnvolle statistische Aussagen über die räumliche Verteilung zu machen. Mit LOFAR ist dies kein wirkliches Problem, da man gut und gerne eine der acht Antennenkeulen für ein so wichtiges Experiment über einen solchen Zeitraum zur Verfügung stellen kann. In der Ära der Präzisions-Kosmologie wäre dann auch der letzte große Parameter festgeklopft. Hochfrequenz- und Niederfrequenz-Radioastronomie hätten damit die fundamentalen Beiträge zur Kosmologie geliefert.

Entstehung der ersten Schwarzen Löchern und Galaxien im Universum

Natürlich ging die Entwicklung des Universums nach Urknall, Rekombination und Reionisation weiter: Galaxien und Galaxienhaufen bildeten sich und die ersten Schwarzen Löcher nahmen ihre Aktivität auf. Wie wir heute wissen, haben sich dann Schwarze Löcher und Galaxien eng gekoppelt zusammen weiterentwickelt. Beides, Sternentstehung und Aktivität Schwarzer Löcher, ist eng mit der Produktion von Radiostrahlung verbunden. Deren Helligkeit steht in sehr guter Korrelation zum jeweiligen Niveau der Aktivität. Das emittierte Radiospektrum hat darüber hinaus eine steile Form und steigt zu niedrigen Frequenzen hin stark an. Bei der niedrigen Auflösung bisheriger Niederfrequenz-Teleskope war es aber kaum möglich, einzelne Galaxien voneinander zu unterscheiden. LOFAR mit seiner Auflösung und Empfindlichkeit ist daher ideal geeignet, viele dieser Quellen zu lokalisieren. Eine Starburstgalaxie mit einer moderaten Sternentstehungsrate von 5 Sonnenmassen pro Jahr lässt sich noch bis zu einer Rotverschiebung von z=2 mit LOFAR sehen, helle Starburstgalaxien sogar bis zum Rand des Universums (Abbildung 10).

Abbildung 10: Extrapolierte Anzahl N von Quellen (Starburstgalaxien),

die mit LOFAR detektiert werden können, als Funktion der Beobachtungsfrequenz

(1400 MHz – 15 MHz), des erreichbaren Flussdichtelimits S und der Dauer der Durchmusterung.

Radiorekombinationslinien

– Rydbergatome im dünnen interstellaren Medium

Radiorekombinationslinien

– Rydbergatome im dünnen interstellaren Medium

Aber nicht nur im Kontinuum lässt sich die Entstehung von Sternen und Galaxien studieren, sondern auch in Linienemission. Jede Galaxie ist durchzogen von einem interstellaren Medium aus Plasma, Gas, und Staub, aus dem sich immer wieder neu Sterne bilden. Bekannt sind hier natürlich die vielen Emissions- und Absorptionslinien im relativ dichten Gas der Molekülwolken, die besonders gut im submm-Bereich (s. ALMA) zu studieren sind. Aber auch das andere Extrem ist höchst interessant: dünnes Gas, welches Sternentstehungsgebiete und Galaxien auf großen Skalen umgibt. Wegen der geringen Dichten ist dieses Gas nur schwer zu entdecken, andererseits können in einer solchen Umgebung auch extreme Rydbergatome bestehen, bei denen einzelne Atome (bzw. deren Elektronenorbits) makroskopische Durchmesser von zehntel Millimeter erreichen können. Quantenübergänge zwischen diesen fast schon freien Elektronenorbits von Wasserstoff führen dann zu sehr niederfrequenten Linien (siehe Kasten) im potentiellen LOFAR-Bereich von 14 MHz (C766α) bis 242 MHz (H300α) – viele davon sind bis heute noch undetektiert. Diese Linien können entscheidende Informationen über physikalische Parameter (Dichte, Temperatur, etc.) in dünnen Bereichen von Sternentstehungsregion liefern, die uns heute nicht zugänglich sind.

Transienten: Explosionen, Ausbrüche, Kosmische Teilchen und Neutrinos

Eines der ganz besonderen Eigenschaften von LOFAR ist seine Fähigkeit, transiente, also sehr kurzzeitige, Phänomene zu entdecken und darauf zu reagieren. Mit acht unabhängigen und in Millisekunden über den ganzen Himmel verteilbaren Antennenkeulen kann LOFAR in kürzester Zeit auf Ereignisse am Himmel reagieren. Die bekanntesten solcher Ereignisse sind Supernovae (Sternexplosionen) und Gamma-Ray-Bursts (GRBs) die mit der Entstehung von Neutronensternen und Schwarzen Löchern (ggf. auch deren Verschmelzung) in Verbindung gebracht werden. Insbesondere bei Gamma-Ray-Bursts kommt es inzwischen auf Sekunden an und noch kein Radioteleskop konnte bisher die „prompte“ GRB-Emission, geschweige denn die Emission des Vorgänger-Objekts messen. Aufgrund des LOFAR Daten-Puffers ist letzteres tatsächlich möglich: bei schnellen Triggern (z.B. von einem Röntgensatellit, einem Gravitationswellen-Detektor oder einem Neutrino-Teleskop) kann man die vor wenigen Sekunden oder Minuten aufgenommenen Rohdaten noch einmal prozessieren und im Nachhinein eine Antennenkeule auf die Explosionsstelle richten. Damit kann man noch den Zeitraum vor und während der Explosion abbilden – eine in der Astronomie einmalige Möglichkeit.

Da LOFAR im Prinzip den ganzen Himmel in seinem Sichtfeld hat, kann man auch regelmäßig Himmelskarten erstellen und im Radiobereich nach neuen Objekten Ausschau halten. Es ist z.B. bekannt, dass Röntgenausbrüche von stellaren Schwarzen Löchern (Mikroquasaren, Röntgendoppelsterne) – für die spezielle Röntgensatelliten gebaut werden – mit Radioausbrüchen einhergehen. Ungefähr einmal im Monat würde LOFAR ein solches Ereignis finden können.

Schließlich lässt sich diese Flexibilität sogar für Teilchenexperimente benutzen. Es ist z.B. bekannt, dass kosmische Strahlung (Teilchen mit extrem hohen Energien bis hin zu 1020 eV, die in kosmischen Quellen beschleunigt werden und auf die Erde prasseln) beim Eintritt in die Erdatmosphäre einen Radioimpuls aussenden (vermutlich Geosynchrotron-Strahlung). Für wenige Nanosekunden ist dieser Radioblitz die hellste Radioquelle am Firmament. Normale Radioteleskope könnten allerdings niemals in einer solchen kurzen Zeit reagieren, dies geht nur mir den virtuellen Antennenkeulen von LOFAR. Interessanterweise erwartet man solche Radioblitze auch von extrem hoch-energetischen kosmischen Neutrinos, wenn sie denn existieren. Man sollte daher in den Rohdaten von LOFAR eine Vielzahl von solchen kosmischen Teilchen- und ggf. auch Neutrino-Ereignissen finden können. Diese müssen dann nur mit einer entsprechenden Software herausgefiltert werden. LOFAR wird damit – fast ungewollt – zu einem wichtigen Astroteilchenphysik-Experiment. Vorbereitende Experimente dafür (LOPES) laufen gerade in Zusammenarbeit mit Luftschauerexperimenten (KASCADE, siehe Abbildung 11) an.

Übrigens können, wie jeder Amateur-Funker weiß, kurzfristige erdnahe Signale (z.B. Radarechos) nicht nur von kosmischen Teilchen, sondern auch von Meteoriten und Mikrometeoriten beim Eintritt in die Atmosphäre produziert werden. Wissenschaftlich ist das durchaus interessant, um z.B. alte Kometenschweife oder gar Staubströme des interstellaren Mediums zu entdecken.

Insgesamt ist die Möglichkeit, Transienten im Radiobereich auf Zeitskalen von Nanosekunden bis hin zu Jahren aufzuspüren eine faszinierende Erweiterung des bislang fast unerforschten Parameterraumes. Es mag durchaus sein, dass die spannendsten Entdeckungen in diesem Bereich noch vor uns liegen.

Sonnensystem, Weltraumwetter and Planeten

Eine traditionelle Anwendung niederfrequenter Radioastronomie ist nach wie vor das Sonnensystem. Sonneneruptionen kann man schon mit relativ simplen Antennen sehr schön in ihrer zeitlichen und ihrer Frequenz-Entwicklung studieren. Solche Ausbrüche haben aber auch einen signifikanten Einfluss auf die Erde, was unter dem Begriff „Weltraumwetter“ bekannt geworden ist. Im schönsten Fall kann dies zu herrlichen Nordlichtern und im schlimmsten Fall zum Totalverlust vonSatelliten führen.

Ein interessanter Aspekt von LOFAR ist, dass es nicht nur diese Ausbrüche sofort detektieren, sondern auch die weitere Entwicklung der durch das Sonnensystem eilenden Plasmaturbulenzen tomographisch abbilden kann. Das ausgestoßene heiße Sonnenplasma führt nämlich dazu, dass kosmische Hintergrundquellen im Radiolicht anfangen zu flimmern („interplanetare Szintillation“, Abbildung 12). Durch die schnelle Beobachtung vieler Hintergrundquellen, wie es mit LOFAR möglich (und zur Kalibration auch nötig) ist, lassen sich Dichte und Position des Sonnenwindes in dreidimensionaler Verteilung und in seiner zeitlichen Entwicklung verfolgen. Eine noch weitergehende Untersuchung des Sonnenwind-Plasmas kann man im Prinzip erreichen, wenn man gezielt Radarwellen in Richtung Sonne strahlt und deren Streuung mit LOFAR wieder empfängt. Dies wird im Rahmen des LOIS-Projekts (LOFAR-Outrigger In Sweden, http://lois-space.org/) in Zusammenhang mit LOFAR versucht werden.

Allerdings ist nicht nur die Sonne ein bekannter Radiostrahler. Auch Jupiter (Abbildung 13) hat extrem helle Radioemission (Zyklotronstrahlung), die in Ausbrüchen bis zu einem Mega-Jansky bei 10 MHz betragen kann und dann zu hohen Frequenzen hin stark abfällt. Diese Emission ist eine Funktion des Magnetfeldes und kann im Prinzip auch zu höheren Frequenzen hin verschoben werden. Insofern ist diese Radioemission auch eine neuartige Möglichkeit, um jupiterähnliche Planeten außerhalb des Sonnensystems direkt zu entdecken.

Erdähnliche Planeten sind damit nicht zu finden. Dies ginge nur dann, wenn es dort Bewohner mit UKW-Funk oder sogar starken niederfrequenten Radar-Sendern (wie z.B. einem extraterrestrischen LOIS) gäbe. Schon lange suchen SETI-Begeisterte in den USA (SETI=Search for Extraterrestrial Intelligence) nach solchen Signalen. Im Prinzip wäre LOFAR dafür ein perfekt geeignetes Instrument – allerdings gibt es zuwenig spleenige, reiche Europäer, die eine solch riskante LOFAR-Anwendung finanzieren würden.

Atmosphäre und Ionosphäre

Zum Schluss sollte man noch einen weiteren interessanten Nebeneffekt von LOFAR nicht vergessen. Zwar kann man niederfrequente Radiostrahlung auch problemlos bei Regen beobachten, aber dennoch wird die empfangene Radiostrahlung über alle Frequenzen hinweg von der Atmosphäre beeinflusst. Bei hohen Frequenzen ist es bekanntlich die Troposphäre, während bei niedrigen Frequenzen die Ionosphäre die Wellenfronten verändert. Dieser Effekt muss korrigiert werden, um Radiointerferometrie erst möglich zu machen. Dazu werden mit LOFAR (dank elektronischem Beamforming) in schnellem Wechsel viele bekannte Radioquellen als Kalibratoren beobachtet. Damit kann man mit hoher Genauigkeit den Zustand der Ionosphäre permanent modellieren und überwachen. Externe Einflüsse, wie z.B. die starken Einwirkungen der Sonnenstürme können dann direkt verfolgt werden. Vor kurzem wurde sogar gezeigt, dass selbst kosmische Gamma-Ausbrüche (Inan et al. 1999, http://www-star.stanford.edu/~hail/gammaray.html) unsere äußere Atmosphäre verändern können. Das Magnetfeld unserer Erde und die Ionosphäre bilden einen wirksamen Schutzschild gegen kosmische Teilchen. Zurzeit wird aber kontrovers diskutiert inwiefern diese kosmischen Teilchen zur Wolkenbildung und damit auch zu unserem Gesamtklima beitragen.

Aber nicht nur Atmosphären-Forscher sondern auch Plasmaphysiker benutzen diese Informationen. Sie interessiert besonders, wie sich Plasmaturbulenzen in den extrem dünnen oberen Schichten unserer Atmosphäre fortpflanzen. Dazu kann man natürliche Turbulenzen abwarten oder solche gezielt erzeugen, etwas durch Zünden von Steuerraketen des Space Shuttles oder durch starke Radarstrahlen.

Insgesamt erschließt sich LOFAR also ein interdisziplinäres Feld, das in seiner Breite von kaum einem anderen Experiment erreicht wird. Eine interessante Herausforderung wird sein, ob es den Wissenschaftlern aus den verschiedenen Bereichen gelingt miteinander zu kollaborieren und zu kommunizieren, um eine maximale gegenseitige Befruchtung zu erreichen.

Die Zukunft der Radioastronomie

Nach den großen Erfolgen in der Vergangenheit hat die Radioastronomie ebenso eine große Zukunft. Nach dem 2. Weltkrieg stellte die Radioastronomie die erste große Erweiterung im beobachtbaren Frequenz-Spektrum neben der traditionellen optischen Astronomie dar. Sie hat uns eine völlig neue Welt erschlossen: eine Welt der relativistischen Plasmen, der Magnetfelder, der Hochenergie-Teilchen, der ultra-kompakten Objekte, der Riesen-Atome und Moleküle und der Untersuchung des frühen Universums bis zurück zum Urknall. Heute sind zur Astronomie neue Disziplinen, wie z.B. Röntgen-, Infrarot- und Gamma-Astronomie, hinzugekommen und oft ist es nur in der Zusammenschau aller Wellenlängen möglich, die Physik des Universums zu entschlüsseln.

Hier sind Wissenschaftler aller Disziplinen gefordert, ihr Feld im gegenseitigen Wettbewerb weiterzuentwickeln und der neugierigen Öffentlichkeit wie auch ihren Kollegen die jeweils besten Teleskope und die besten Methoden zur Verfügung zu stellen.

Als die „Älteste unter den Neuen“ ist die Radioastronomie dabei in einer besonderen Verantwortung, der sie sich mit einer Reihe von Großprojekten stellt. ALMA und LOFAR sind schon auf gutem Wege, während sich mit SKA auch bereits die Vision für die weitere Zukunft konkretisiert. Die speziellen, klassischen Eigenschaften der Radiowellen werden es auch in Zukunft erlauben, präzise und fundamentale Probleme in einzigartiger Weise zu lösen. Wie das Beispiel LOFAR zeigt, manchmal sogar mit einer Technik, die im Prinzip in jedem modernen Haushalt zu finden ist: Radioempfänger und Internet.

Draft: Heino Falcke, Version 27.11.03